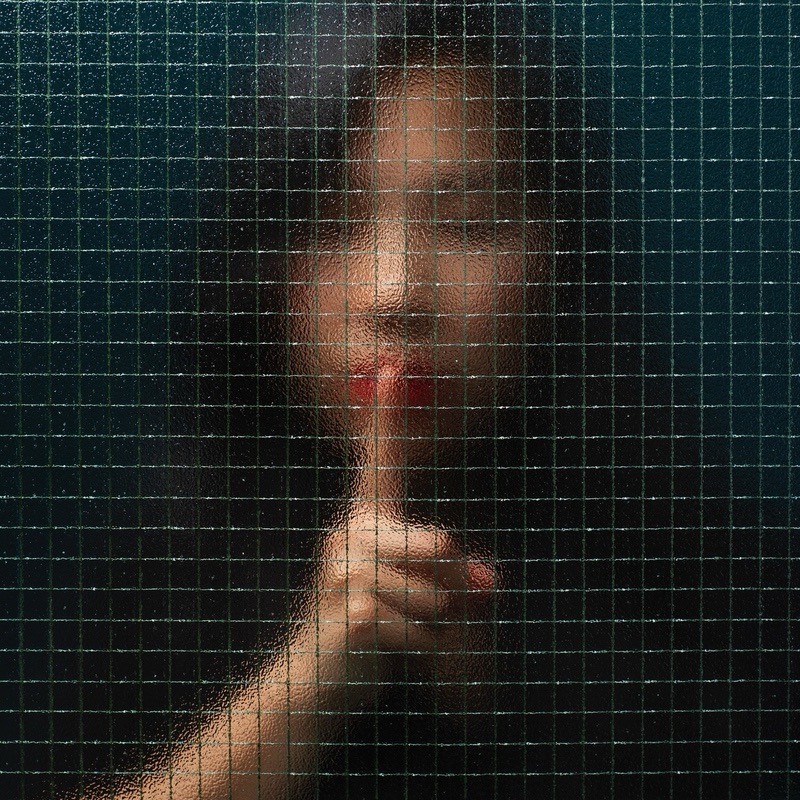

Cada 25 de noviembre miramos de frente la violencia contra las mujeres. Pero hay una forma de violencia que muchas veces pasa desapercibida: la que llega en forma de imágenes y vídeos falsos creados con inteligencia artificial, los llamados deepfakes.

Un deepfake es, en simple, una foto o vídeo manipulado con IA para mostrar a alguien haciendo o diciendo algo que nunca hizo. El dato que más duele es que el 96% de los deepfakes generados son de contenido sexual y no consentido, y sus principales víctimas son mujeres. No son “bromas”: son herramientas para dañar, extorsionar, controlar o silenciar.

Organismos internacionales ya han advertido que la combinación de inteligencia artificial y anonimato está alimentando el aumento de la violencia digital contra las mujeres. Y los sistemas jurídicos empiezan, poco a poco, a reaccionar: en España, el Gobierno ha aprobado tipificar como delito los deepfakes de contenido sexual y el grooming; en otros países se han impulsado leyes específicas contra los deepfakesy la “pornovenganza”. Incluso hemos visto sanciones económicas por difundir imágenes falsas de desnudos de menores. Son señales claras de que esta violencia ya no se considera un daño “menor” ni “virtual”.

Como parte de WAI Spain, y trabajando día a día con tecnología e IA, creo que la regulación es necesaria, pero no suficiente. La misma inteligencia artificial que se usa para dañar puede y debe formar parte de la solución:

- Detectando automáticamente contenido manipulado antes de que se viralice.

- Ayudando a gestionar grandes volúmenes de denuncias para identificar patrones y priorizar casos críticos.

- Generando datos agregados que permitan diseñar políticas públicas más eficaces y con enfoque de género.

Visibilizar lo que no se ve es siempre el primer paso. El siguiente es claro: decidir que la IA se use para proteger derechos y dignidad, no para vulnerarlos. Detrás de cada imagen falsa hay una mujer real, con una vida real, que merece toda nuestra protección.

Suscríbete al boletín:

Suscribete Gratis